Les processeurs de la société anglaise rivalisent favorablement avec ceux du leader Nvidia dans les bancs d'essai MLPerf dédiés à l'accélération de machine learning.

Le consortium MLCommons vient de communiquer de nouveaux résultats dans le cadre de ses bancs d'essai MLPerf Training v1.0, qui jaugent les performances de différents accélérateurs IA sur un certain nombre d'algorithmes de machine learning. Les soumissions des différents participants sont dites soit fermées (le même modèle de référence est utilisé par tous), soit ouvertes (l'implémentation des modèles peut différer d'un participant à l'autre). Dans cette version 1.0, MLPerf se voit agrémenté de deux nouveaux bancs d'essai dédiés respectivement à la conversion de voix en texte RNN-T et à l'imagerie médicale 3D U-Net.

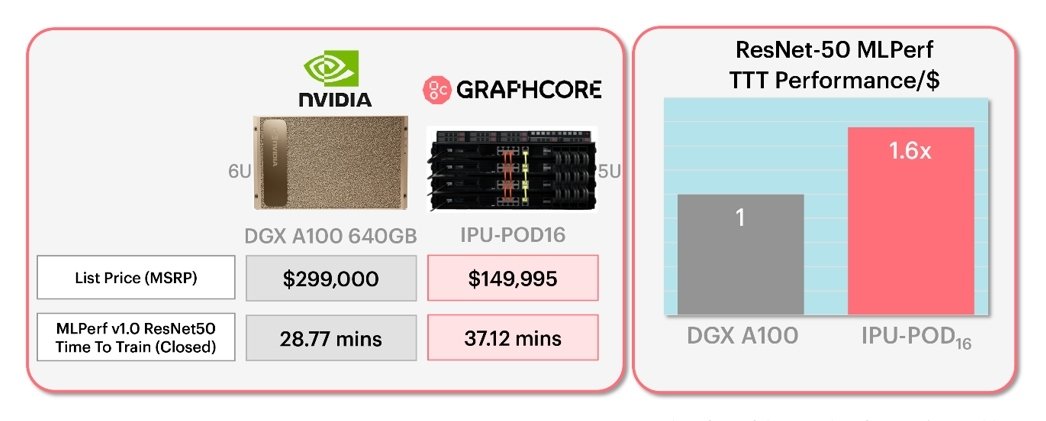

Si la majorité des participants à ces bancs d'essai sont des fabricants de cartes, d'ordinateurs et de serveurs (Dell, Fujitsu, Gigabyte, Nettrix, Lenovo, Inspur...) utilisant comme accélérateur IA des processeurs Nvidia A100, on notera également, pour la première fois, la présence des processeurs de l'Anglais Graphcore. Ce dernier se réjouit d'ailleurs des résultats obtenus par ses cartes IPU-POD16 et IPU-POD64, avec un rapport performance/coût meilleur de 60% et 30% par rapport aux DGX A100 de Nvidia sur les algorithmes classiques ResNet-50 et BERT, respectivement. Graphcore avance même un gain de 280% sur le plus récent EfficientNet-B4. « Passer les tests MLPerf sur les algorithmes ResNet-50 et BERT nous permet de démontrer nos performances sur les modèles IA les plus utilisés aujourd'hui, mais notre architecture a été conçue pour briller surtout sur les applications IA les plus avancées » explique Graphcore.