Avec sa troisième génération de processeurs Epyc, AMD promet un gain de 19 % en nombre d'instructions traitées par cycle d'horloge.

Le marché des serveurs de données est actuellement très dynamique, porté par l'envolée des débits de données (démocratisation de la fibre optique, arrivée de la 5G) et par le travail et l'enseignement à distance imposés par la pandémie. Pour autant, c'est un marché stable en matière d'architectures : vu le prix des équipements et leur longévité espérée, les fabricants d'équipements réseaux restent le plus souvent fidèles à leurs fournisseurs habituels. La forte progression actuelle des ventes de processeurs réseaux estampillés AMD est donc à relativiser. Intel continue de dominer ce marché de la tête et des épaules. D'après une récente étude de la société d'analyse Mercury Research, Intel en détenait 92,9 %, contre 7,1 % pour AMD. Mais AMD ne pesait que 4,5 % un an auparavant, ce qui montre l'impact fort de ses processeurs réseaux Epyc dans ce qui était jusqu'à présent un pré carré réservé à Intel. Une concurrence renouvelée qui bénéficie avant tout à leurs clients, puisqu'elle tend à faire baisser les prix – Intel n'hésitant pas à contre-attaquer en diminuant ses tarifs sur un secteur où les marges sont traditionnellement élevées – tout en stimulant l'innovation technologique. Le dernier round en date marque l'arrivée de nouvelles générations de processeurs réseaux chez les deux rivaux, à savoir les Epyc Milan chez AMD et les Xeon Ice Lake SP chez Intel.

DU ZEN 3 DANS LES PROCESSEURS EPYC

AMD a dégainé en premier sa troisième génération de proces-seurs réseaux Epyc. Cette fournée référencée 7003 et estampillée Milan s'appuie sur les déjà bonnes performances de la précédente (Rome), avec laquelle elle partage le même brochage, ce qui simplifie la conception et la mise à jour des systèmes. Le gain en performances par cycle d'horloge atteint 19 % en moyenne selon AMD. Ce gain est principalement dû à l'adoption dans la génération Milan du cœur Zen 3, lequel constitue une mise à jour significative de la microarchitecture d'AMD avec notamment une mémoire cache bien plus efficace.

Déjà disponible depuis la fin de l'année dernière dans des processeurs pour PC Ryzen, Zen 3 repose sur des blocs de huit cœurs communiquant chacun directement avec une mémoire cache de niveau 3 de 32 Mo, là où les Zen 2 étaient regroupés par quatre autour de 16 Mo de cache L3. Résultat : une utilisation bien plus efficace du cache, avec une latence amoindrie. Pour traiter 19 % d'instructions supplémentaires par cycle d'horloge, AMD a procédé à de multiples améliorations de l'architecture interne du cœur, par exemple au niveau de la prédiction d'embranchement, de la latence de traitement et des opérations de chargement/ stockage des données. Chaque cœur bénéficie de 32 Ko de cache de niveau 1 pour les instructions et autant pour les données, et de 512 Ko de cache L2. La communication entre les cœurs est accélérée par le recours à des liaisons Infinity Fabric à 18 Gbit/s (16 Gbit/s pour les Zen 2), tandis que les lignes de transmission PCIe 4.0 peuvent désormais fonctionner en mode Extended Speed qui, comme son nom l'indique, autorise un surcroît de bande passante si tant est que la carte mère ait été conçue pour le supporter.

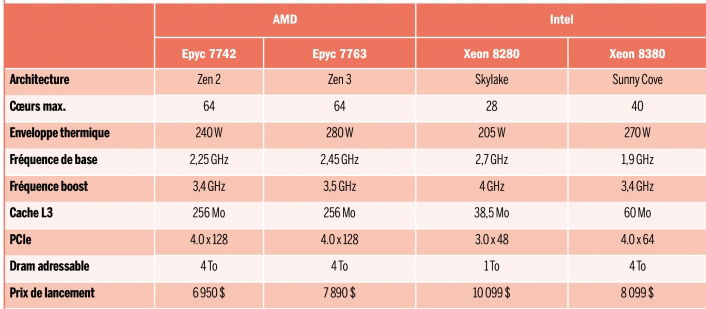

Les deux dernières générations de processeurs réseaux AMD et Intel Les avantages de l'architecture Zen et de la gravure en process 7 nm expliquent le fait qu'AMD gagne des parts de marché sur Intel en processeurs réseaux. |

Serveurs : les processeurs x86 ne sont plus seuls

Une double concurrence menace le quasi-monopole des processeurs à cœurs x86 sur le marché des serveurs de données. La première vient des fabricants de serveurs eux-mêmes, tentés de concevoir leurs propres processeurs qu'ils peuvent alors optimiser à leur guise. Amazon utilise par exemple depuis plusieurs années maintenant des processeurs Graviton à cœurs Arm Neoverse conçus en interne. Les récents Graviton2 embarquent ainsi 64 cœurs tournant jusqu'à 2,5 GHz. Pour Intel et AMD, la menace provient d'autre part de jeunes pousses comme Ampere, dont le processeur Altra comprend, lui, 80 cœurs Arm Neoverse à 3,3 GHz, en attendant l'Altra Max promis à 128 cœurs pour cette année. Longtemps annoncée sans réels résultats sur le terrain, l'offensive des cœurs Arm dans les centres de données commence à se matérialiser, avec les avantages d'architectures récentes et compactes. |

En outre, les améliorations apportées au cœur Zen 3 lui permettent d'être cadencé à une fréquence légèrement supérieure, alors même que les puces Rome et Milan sont produites avec la même technologie de fabrication en 7 nm. Au total, les performances brutes gagnent donc entre 20 et 30 %. Les Epyc Milan seraient par conséquent les premiers à dépasser leurs homologues Intel en fonctionnement mono-tâche, et renforcent encore leur suprématie dans les bancs d'essai multitâches.

Autre nouveauté : l'ajout d'une fonction de sécurisation des données dite SEV-SNP (secure encrypted virtualization-se-cure nested paging). Cette fonction s'appuie sur les précé-dentes protections SEV, qui visent à isoler les machines virtuelles de l'hyperviseur pour assurer leur protection. Étaient déjà utilisés sur les précédents processeurs réseaux AMD le cryptage AES des données avec une clé unique par machine virtuelle, et le cryptage du registre de machines virtuelles à chaque transition de l'hy-perviseur. SEV-SNP ajoute des protections hardware renforçant l'intégrité des données (corruption, remplacement de page mémoire, etc.).

La famille Milan ne compte pas moins d'une vingtaine de membres. À son sommet figure le 7763, dont les 64 cœurs turbinent jusqu'à 2,45 GHz en mode normal et 3,5 GHz en mode boost pour une enveloppe thermique atteignant tout de même 280 W et une mémoire cache de niveau 3 de 256 Mo.

Le reste de la gamme comporte différentes combinaisons de nombres de cœurs (8, 16, 24, 28, 32, 48, 56 ou 64), et de tailles de cache (64, 128 ou 256 Mo). Les fréquences, elles, s'échelonnent entre 2 et 3,7 GHz en mode normal et entre 3,45 et 4,1 GHz en mode boost, avec des budgets ther-miques démarrant à 155 W. La gamme de prix indicatifs pour 1 000 pièces varie de 913 à 7 890 dollars – le plus souvent avec une hausse de prix de 5 à 15 %. Par exemple, le modèle 32 cœurs le plus rapide, le 7543, est proposé à 3 761 dollars, à comparer au prix indicatif de 3 400 dollars pour le précédent 7542. Prochaine étape pour AMD : des processeurs réseaux Epyc à cœur Zen 4 (nom de code : Genoa) et gravés en process 5 nm.

INTEL MISE SUR SON ECOSYSTÈME

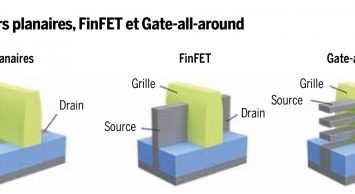

De son côté, Intel a procédé au lancement de sa troisième génération de processeurs Xeon Scalable, qui répond au nom de code Ice Lake-SP. Avec, à la clé, deux grosses avancées. D'une part, ces circuits sont désormais gravés en technologie FinFET 10 nm, ce qui permet de caser davantage de cœurs sur une même surface. L'étendard Platinum 8380 embarque ainsi 40 cœurs, là où la précédente génération s'arrêtait à 28. L'autre nouveauté réside dans l'adoption de la microarchitecture Sunny Cove en lieu et place de Skylake. Chaque cœur Sunny Cove traiterait environ 20 % d'ins-tructions supplémentaires par cycle d'horloge grâce à de multiples modifications architecturales. En outre, le passage de six à huit canaux d'accès mémoire DDR4, de nouvelles techniques de prefetch, des mémoires cache de niveau 1 et 2 plus importantes (48 Ko et 1,25 Mo, contre 32 Ko et 1 Mo sur la génération précédente) et diverses optimisations accéléreraient la transmission des données. Des modifications qui nécessitent toutefois de changer de socket et donc de carte mère, contrairement aux Epyc Milan d'AMD.

Les Xeon 3 sont répartis dans les segments Platinum, Gold et Silver chers à Intel – à noter la disparition des modèles estampillés Bronze. La quarantaine de circuits lancés par l'Américain court du modeste 4309 (8 cœurs, 105 W, 12 Mo de cache L3, mémoire DDR4-2666, 501 $) au 8380 (40 cœurs, 270 W, 60 Mo, mémoire DDR4-3200, 8 099 $). Certains de ces processeurs sont en outre affublés de suffixes. Les modèles T bénéficient d'une gamme de température étendue entre - 40 °C et + 125 °C et d'une longévité accrue. Les processeurs M, N, P et V sont spécialisés au niveau logiciel pour un domaine d'application précis, respectivement le multimédia, les réseaux, les clouds IaaS et les clouds SaaS. On trouve également des modèles U, qui ne conviennent qu'aux cartes mères à un seul socket, des Y supportant différents profils de performance SST-PP 2.0, des versions S dotées d'enclaves de mémoire protégées SGX de 512 Go, et même un modèle Q requérant un refroidissement liquide. Tous ces circuits accèdent à des ports PCIe 4.0, contrairement aux précédents modèles d'Intel bloqués en PCIe 3.0.

« Xeon est la seule famille de processeurs pour serveurs dotés d'une accélération IA », avance Lisa Spelman, vice-présidente d'Intel pour les processeurs serveurs et les mémoires.

Intel compte aussi sur les spécificités matérielles et logicielles de ses Xeon pour se démarquer. À commencer par l'intelligence artificielle ici accélérée, contrairement aux Epyc d'AMD. Un argument solide, mais qui ne vaut que pour les tâches où l'IA n'intervient qu'à la marge, faute de quoi les centres de données tendent à avoir recours à des accélérateurs dédiés. En termes de sécurité, Intel met en avant l'extension de ses enclaves de mémoire SGX, mais aussi de nouvelles fonctions comme le cryptage total de la mémoire (total memory encryption, TME) pour éviter les attaques physiques, la protection et récupération de firmware (platform firmware resilience, PFR) ou encore l'accélération d'instructions de cryptage (notamment via les instructions vectorielles AVX-512).

DES GÉNÉRATIONS DE PLUS EN PLUS RAPPROCHÉES

Les améliorations apportées aux Xeon 3 sont donc nombreuses et significatives. Pour autant, ces processeurs peinent à concurrencer leurs rivaux provenant d'AMD, qui conservent ici une marge d'avance dans leur rapport performances/prix. Pas étonnant, donc, qu'Intel mette en avant les vertus de la plateforme Xeon Scalable et pas seulement celles des processeurs Xeon 3. L'Américain inscrit en effet ses circuits dans une offre bien plus large qui comprend ses interfaces optiques et Ethernet, ses mémoires à très haut débit Optane (barrettes 200 Series allant jusqu'à 6 To et disques durs SSD P5800X) ou encore ses circuits logiques programmables Agilex. Tous ces éléments, optimisés pour les processeurs Xeon, doivent être pris en compte.

L'autre avantage d'Intel réside dans sa position de leader. Depuis 2013, plus d'un milliard de cœurs Xeon ont été déployés dans le cloud ; la génération Xeon Scalable, elle, en est déjà à plus de 50 millions de proces-seurs livrés. Cet héritage tant matériel que logiciel est à même de résister à la concurrence : tel un paquebot, le marché des serveurs ne saurait virer de bord en un claquement de doigts. Au 1 er trimestre 2021, plus de 200 000 processeurs Xeon Scalable de troisième génération ont déjà été livrés. La prochaine vague, baptisée Sapphire Rapids, supportera la mémoire Dram DDR5 et des ports PCIe de cinquième géné-ration. Elle pourrait être échantillonnée auprès de clients dès la fin de l'année 2021, avant un lancement officiel l'an prochain.