A l’occasion de sa GPU Technology Conference (GTC), Nvidia a présenté sa prochaine puce graphique baptisée Blackwell (B200) en hommage au mathématicien africain-américain David Blackwell. Selon l’Américain, elle permettra de faire tourner des algorithmes d’intelligence artificielle générative sur des modèles de langage à un trillion de paramètres en divisant par 25 (au maximum) le coût et la consommation par rapport à la génération précédente.

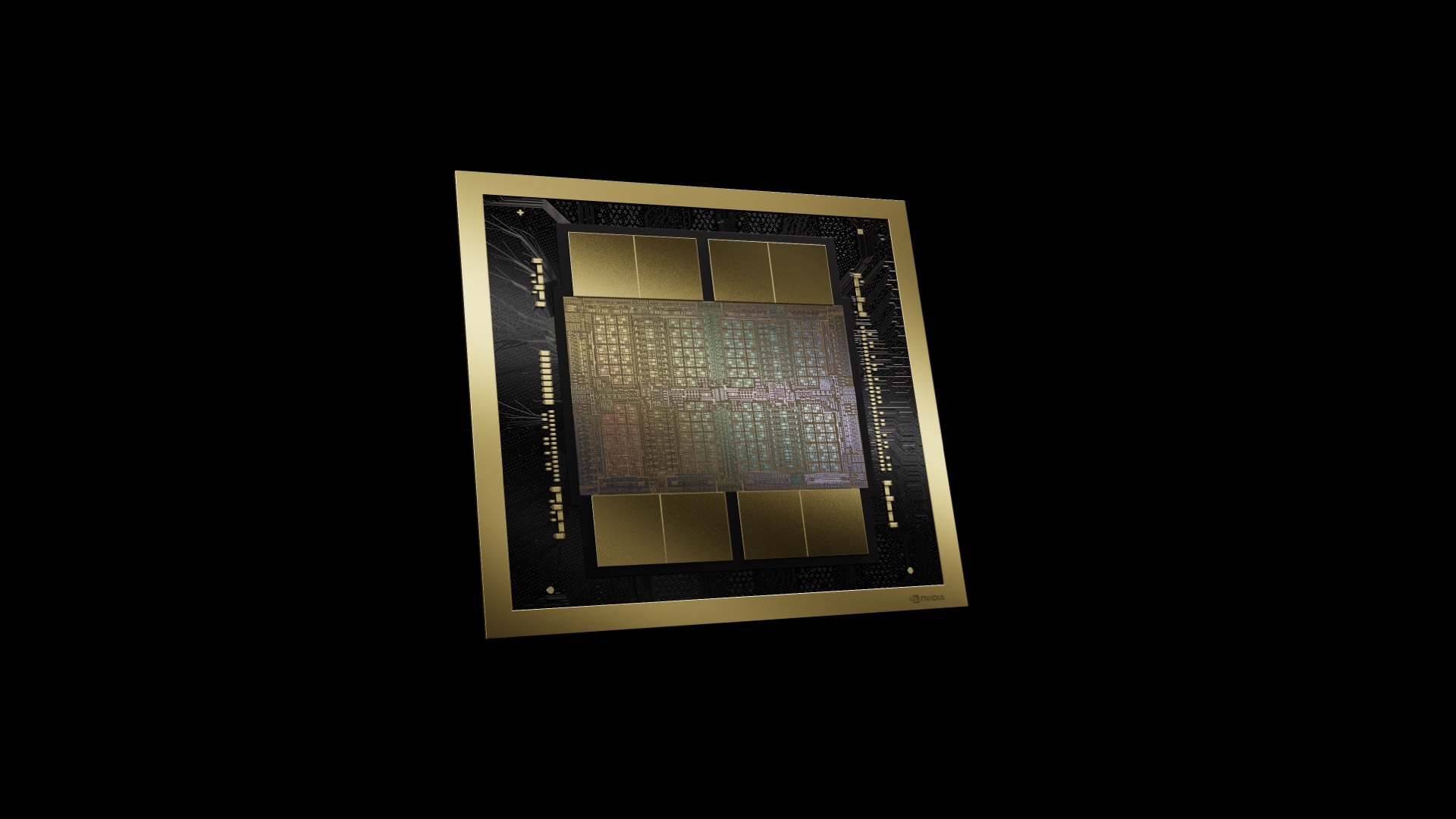

Blackwell s’appuie pour cela sur six innovations qualifiées de « révolutionnaires » par Nvidia. Le boîtier contient 208 milliards de transistors répartis sur plusieurs chiplets fabriqués dans un process 4nm du Taïwanais TSMC et connectés par des liaisons à 10To/s. Des connexions externes NVLink de cinquième génération, débitant jusqu’à 1,8To/s, permettent de relier jusqu’à 576 processeurs. Au sein des processeurs, un moteur RAS est dédié à améliorer la fiabilité et la disponibilité des puces. La sécurisation des données a également été renforcée au moyen de nouveaux protocoles de cryptage de interfaces, tandis qu’un moteur de décompression mis à jour accélère les requêtes vers les bases de données. Enfin, les algorithmes gagnent en échelonnement avec par exemple le support de l’inférence IA en virgule flottante sur quatre bits.

Concrètement, Nvidia regroupe deux de ces GPU B200 et un processeur Grace sur le Grace Blackwell GB200. Ces GB200 sont à leur tour associés par lots de 36 dans des serveurs refroidis par liquide, les GB200 NVL72, qui disposent également de cartes de traitement de données BlueField-3 servant à accélérer l’accès au cloud, le stockage et le cryptage. Cette plateforme se comporte alors comme un seul GPU doté de 30To de mémoire et d’une puissance équivalant à 1,4 exaflop. Autre dispositif proposé par Nvidia : une carte référencée HGX B200, qui comprend huit GPU B200 et cible les serveurs à processeurs x86. Tous ces produits Blackwell seront disponibles plus tard dans l’année.