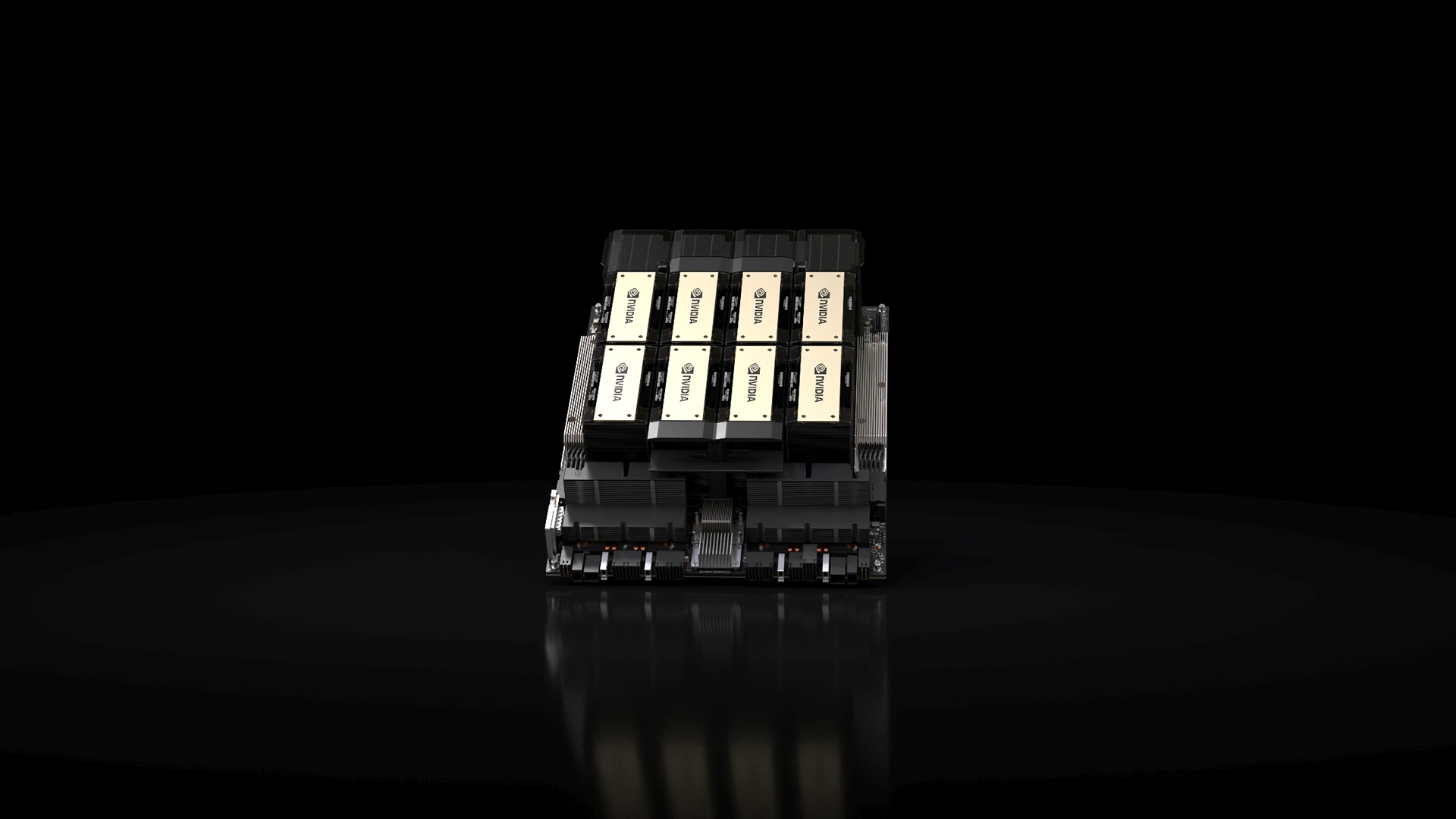

Nvidia pousse son avantage en intelligence artificielle. L’Américain vient de présenter officiellement la plateforme HGX H200, basée sur l’architecture Hopper et combinant les cœurs GPU Tensor H200 et, pour la première fois, une mémoire HBM3e. Grâce à ces 141Go de mémoire à très large bande passante, le H200 délivre 4,8To/s, deux fois plus que son prédécesseur, l’A100. Le H200 sera disponible sur des cartes HGX pour serveurs à quatre et huit voies, et, associé à une mémoire HBM3e sur le module Grace Hopper GH200. Une carte HGX H200 à huit voies délivre une puissance de calcul de 32Pflops au format FP8 et une bande passante de 1,1To. Les premiers systèmes en bénéficiant devraient être commercialisés au deuxième trimestre 2024.

Nvidia double la puissance de ses puces IA

© Nvidia